Kimi K2: De Agentic AI-Revolutie van Moonshot AI

Kimi K2 is een Large Language Model (LLM) met een biljoen parameters, ontwikkeld door Moonshot AI, een in Peking gevestigd bedrijf op het gebied van kunstmatige intelligentie. Het model, dat in juli 2025 werd uitgebracht, maakt gebruik van een Mixture-of-Experts (MoE)-architectuur en is primair ontworpen voor “agentic” taken, zoals autonoom gereedschapsgebruik, complexe software engineering en meerstaps redeneren.

Gepositioneerd als een open-weight model onder een aangepaste MIT-licentie, is Kimi K2 bedoeld als een hoogwaardig alternatief voor closed-source frontier-modellen. Het dient als de basis voor opeenvolgende iteraties, waaronder de geüpdatete Kimi-k2-Instruct-0905 en de multimodale Kimi K2.5.

Wat is Kimi K2?

Kimi K2 is een sparse MoE-model met in totaal 1 biljoen parameters, waarvan er 32 miljard actief zijn per token tijdens de inference. Deze architectuur stelt het model in staat om een enorme kennisbank te benutten, terwijl de computationele efficiëntie van een veel kleiner systeem behouden blijft. Het model is getraind op 15,5 biljoen tokens en is geoptimaliseerd voor agentic intelligence.

In tegenstelling tot standaard chatmodellen die zich richten op dialoog, is Kimi K2 ontworpen om omgevingen waar te nemen, externe tools (API’s, databases, browsers) aan te roepen en meerstaps plannen uit te voeren om een specifiek doel te bereiken.

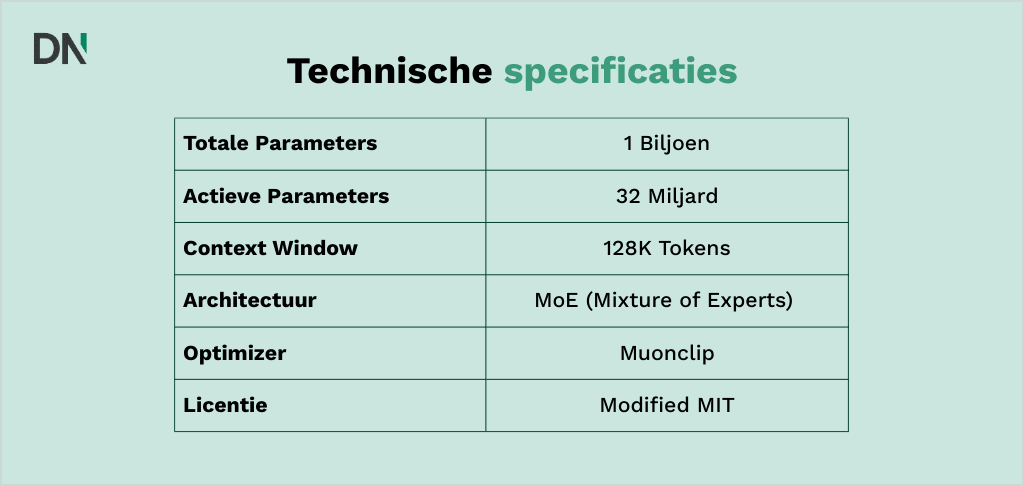

Technische specificaties

- Totaal aantal parameters: 1 biljoen

- Actieve parameters: 32 miljard

- Architectuur: Mixture-of-Experts (MoE) met 384 experts (8 geselecteerd per token).

- Context window: 128.000 tokens (uitgebreid naar 256.000 in latere versies).

- Optimizer: MuonClip, een op maat gemaakte optimizer ontworpen om trainingsinstabiliteit op schaal te voorkomen.

- Licentie: Aangepaste MIT (open-weight voor onderzoek en commercieel gebruik).

Kernvarianten van de Kimi K2-serie

Moonshot AI heeft verschillende versies van het K2-model uitgebracht om tegemoet te komen aan verschillende behoeften bij deployment. Bedrijven hebben vaak een specifieke versie nodig, afhankelijk van of ze onderzoek doen of een consumentgerichte AI-chatbot inzetten.

Kimi-K2-Base

De base-versie is het ruwe, voorgetrainde model zonder instruction tuning of veiligheidsafstemming. Het wordt voornamelijk gebruikt door onderzoekers en ontwikkelaars die fine-tuning willen uitvoeren op bedrijfseigen datasets voor specifieke niche-toepassingen.

Kimi-K2-Instruct

De instruct-versie heeft Reinforcement Learning from Human Feedback (RLHF) ondergaan en is geoptimaliseerd voor algemene chat, het opvolgen van instructies en agentic workflows. Het is de standaardkeuze voor directe AI-implementatie in bestaande softwarestacks.

Kimi-K2-Thinking

Deze variant, uitgebracht in november 2025, introduceert uitgebreid chain-of-thought (CoT) redeneren. Het genereert interne redeneerstappen voordat het een definitieve output geeft, waardoor het complexe wiskundige en logische problemen kan oplossen die standaardmodellen mogelijk niet kunnen aanpakken.

Aan de slag met Kimi K2

Aan de slag gaan met Kimi K2 is gestroomlijnd via twee primaire kanalen: de consumentgerichte webinterface en het op ontwikkelaars gerichte API-platform. Of je nu op zoek bent naar onmiddellijke AI-implementatie of een sandbox voor AI training, beide methoden bieden toegang tot de kerncapaciteiten van het model.

De online versie (Kimi.ai)

Voor niet-technische gebruikers of degenen die de chat- en redeneercapaciteiten van het model direct willen testen, biedt Moonshot AI een gratis te gebruiken webinterface.

- Toegang: Bezoek kimi.ai en registreer een account met een mobiel nummer of e-mailadres.

- Modi: De webinterface stelt gebruikers in staat om te schakelen tussen de modi “Standaard” en “Thinking”. De laatste wordt aangedreven door de chain-of-thought architectuur van de Kimi K2-serie.

- Bestandsondersteuning: Je kunt PDF’s, spreadsheets en afbeeldingen direct in de chat uploaden. Het context window van 256.000 tokens maakt de analyse van volledige boeken of technische handleidingen in enkele seconden mogelijk.

Het Moonshot AI Open Platform (API)

Ontwikkelaars en ondernemingen kunnen Kimi K2 direct in hun eigen applicaties integreren via het Moonshot AI Open Platform. De API is volledig compatibel met het OpenAI SDK-formaat, wat de overgang vereenvoudigt voor teams die al andere LLM-providers gebruiken.

Technische installatie

Om een API-verbinding tot stand te brengen, moet je eerst een API-key genereren in de developer console. Een standaardimplementatie in Python ziet er als volgt uit:

Python

from openai import OpenAI

client = OpenAI(

api_key="JOUW_MOONSHOT_API_KEY",

base_url="https://api.moonshot.ai/v1",

)

completion = client.chat.completions.create(

model="kimi-k2-turbo-preview",

messages=[

{"role": "system", "content": "Je bent Kimi, een behulpzame AI-assistent."},

{"role": "user", "content": "Analyseer deze data voor agentic workflow efficiëntie."}

],

temperature=0.6

)

print(completion.choices[0].message.content)

Tarieven en niveaus

De API is competitief geprijsd om adoptie door ontwikkelaars te stimuleren. Vanaf begin 2026 is de prijsstructuur ongeveer:

- Input tokens: $0,15 per miljoen tokens (met cache-hits).

- Output tokens: $2,50 per miljoen tokens.

Community en toegang via derden

Omdat Kimi K2 een open-weight model is, is het ook beschikbaar via infrastructuurproviders van derden. Dit geniet vaak de voorkeur van Europese ondernemingen die specifieke data-residency of lagere latentie vereisen:

- OpenRouter: Biedt een universele API voor toegang tot Kimi K2 en K2.5 naast andere frontier-modellen.

- Hugging Face: De modelgewichten kunnen worden gedownload voor lokale deployment of private cloud-hosting op Hugging Face.

Benchmarks en vergelijkende analyse

Kimi K2 vertoont competitieve prestaties op benchmarks voor coderen, wiskunde en agentic search, waarbij het vaak beter presteert dan oudere versies van propriëtaire modellen zoals GPT-4.

Software engineering (Coderen)

Op de SWE–Bench Verified benchmark, die het oplossen van echte GitHub-issues vereist, behaalde Kimi K2 een score van 65,8%. Hiermee presteerde het beter dan GPT-4.1 (54,6%) en evenaarde het de capaciteiten van andere frontier-modellen zoals Claude Opus in specifieke codeertaken.

Wiskundig redeneren

In de wiskunde behaalde het model 97,4% op MATH-500, wat duidt op een hoge vaardigheid in wiskundige problemen op universitair niveau. De prestaties op dit gebied worden verder verbeterd in de “Thinking”-variant, die 99,1% bereikte op AIME 2025.

Agentic tool-gebruik

Een belangrijk onderscheidend kenmerk van Kimi K2 is het vermogen om lange reeksen tool-aanroepen te verwerken. In technische evaluaties voerde het model met succes 200 tot 300 opeenvolgende tool-aanroepen uit zonder het oorspronkelijke doel van de gebruiker uit het oog te verliezen. Dit maakt het geschikt voor complexe onderzoekstaken waarbij het web wordt doorzocht, data wordt geanalyseerd en rapporten worden gegenereerd in één continue lus.

| Benchmark | Kimi K2 (Base) | GPT-4.1 | Claude Opus |

| MMLU (Algemene kennis) | 89,5% | 88,0% | 86,8% |

| SWE-Bench Verified (Code) | 65,8% | 54,6% | 66,0% |

| MATH-500 (Wiskunde) | 97,4% | 93,0% | 91,5% |

| BrowseComp (Agentic search) | 60,2% | 35,0% | 24,1% |

Belangrijke technische innovaties

De prestaties van Kimi K2 worden toegeschreven aan verschillende doorbraken in architectuur en training die het onderscheiden van standaard Transformer-modellen.

Mixture-of-Experts (MoE) efficiëntie

Kimi K2 maakt gebruik van een MoE-architectuur met 384 experts. Door tokens naar slechts 8 experts (de “actieve” parameters) te routeren, vermindert het model latentie en energieverbruik. Moonshot AI heeft ook het aantal attention-heads verminderd in vergelijking met andere modellen, wat helpt om de stabiliteit te behouden tijdens operaties met een lange context.

MuonClip optimizer

Het trainen van een model met een biljoen parameters wordt vaak geplaagd door “loss spikes” en “logit explosions”. Moonshot AI ontwikkelde de MuonClip optimizer, die een techniek genaamd qk-clip gebruikt om gewichten in de query- en key-matrices te herschalen. Dit zorgt voor een soepel trainingsproces en verbetert de uiteindelijke intelligentie van het model bij een beperkte dataset.

Agentic post-training

Om zijn hoge vaardigheid in tool-gebruik te bereiken, onderging Kimi K2 post-training waarin duizenden tool-gebruikstaken in verschillende domeinen werden gesimuleerd. Deze training omvat “self-play” mechanismen waarbij het model communiceert met synthetische tools (API’s, shells en databases) en beloningen ontvangt op basis van taakvoltooiing. Organisaties kunnen deze mogelijkheden verkennen via een op maat gemaakte AI-workshop.

Praktische use cases voor Kimi K2

De “agentic” aard van Kimi K2 maakt het mogelijk om te worden gebruikt voor taken die verder gaan dan eenvoudige tekstgeneratie. Voor ondernemingen die deze oplossingen willen inzetten, is een AI-strategiesessie vaak de eerste stap om deze capaciteiten te koppelen aan bedrijfsdoelen.

- Autonome onderzoeksagents: Kimi K2 kan autonoom webonderzoek uitvoeren door meerdere zoekopdrachten uit te voeren, door links te klikken en bevindingen te synthetiseren in een gestructureerd formaat zoals een spreadsheet of een technisch rapport.

- Geautomatiseerde softwareontwikkeling: Het model fungeert als een geavanceerde “Code Copilot”, in staat om bugs te herstellen in grote codebases. De hoge score op SWE-Bench suggereert dat het de context van een gehele repository kan begrijpen om complexe problemen op te lossen die zich over meerdere bestanden uitstrekken.

- Financiële en data-analyse: Kimi K2 is in staat tot complexe data-analyse, zoals het vergelijken van salaristrends in verschillende sectoren. Het kan data laden, visualisaties genereren (zoals violin plots of staafdiagrammen) en zelfs een eenvoudig HTML-dashboard bouwen om de resultaten weer te geven.

- Workflow-orkestratie: Door integratie met enterprise-API’s kan Kimi K2 projectworkflows met meerdere stappen beheren. Het kan bijvoorbeeld een agenda controleren, vluchten zoeken, een Airbnb boeken en het reisschema samenvatten in een e-mail, dit alles zonder handmatige tussenkomst voor elke stap.

Veelgestelde vragen

Hoe krijg ik toegang tot Kimi K2?

Via de officiële website op kimi.ai of via API-toegang op het Moonshot Open Platform.

Wat zijn de hardwarevereisten om Kimi K2 lokaal te draaien?

Voor het volledige 1T-model is een cluster van GPU’s (bijv. 8x H100 of A100 80GB) vereist. Quantized versies (zoals 4-bit of GGUF) kunnen draaien op hardware met ca. 600GB aan gecombineerd VRAM/RAM.

Is Kimi K2 beter dan GPT-4?

In specifieke agentic taken en coderen (SWE-Bench) presteert Kimi K2 vaak beter dan GPT-4, hoewel GPT-4 in sommige algemene taalverwerkingstaken nog steeds een voorsprong kan hebben.

Wat is het verschil tussen Kimi K2 en Kimi K2.5?

Kimi K2.5 is de multimodale opvolger die ook native vision-capaciteiten (beeld- en videoanalyse) en de “Agent Swarm” technologie introduceert voor parallelle taakuitvoering.