Wat is een klein taalmodel?

Grote taalmodellen (LLMs) zoals ChatGPT halen vaak het nieuws met indrukwekkende algemene vaardigheden. Toch zien steeds meer bedrijven het voordeel van een andere vorm van kunstmatige intelligentie die vaak nóg praktischer is: het Kleine Taalmodel (SLM). Deze modellen bieden een toegankelijk, efficiënt en op maat gemaakt pad naar effectieve AI-integratie binnen bedrijfsprocessen.

In dit artikel leggen we alles uit over kleine taalmodellen, en geven we een duidelijk beeld van hoe ze verschillen van grote taalmodellen. We gaan dieper in op de strategische voordelen ervan, demonstreren praktijktoepassingen en bieden richtlijnen over hoe bedrijven deze AI-tools effectief kunnen benutten om concrete resultaten te behalen.

Kleine taalmodellen begrijpen

Kleine taalmodellen (SLM’s) vertegenwoordigen een gerichte benadering van kunstmatige intelligentie. Ze worden gekenmerkt door een gestroomlijnd ontwerp en optimale prestaties voor specifieke taken. Deze modellen hebben doorgaans minder parameters, variërend van miljoenen tot enkele miljarden, en hebben vaak een omvang van net geen 10 miljard parameters.

De architectuur van een klein taalmodel is geoptimaliseerd voor efficiëntie. Dit betekent dat ze zelfs op apparaten met beperkte middelen, of in omgevingen met weinig internet, geheugen en stroom, prima functioneren. Vaak worden kleine taalmodellen gefinetuned met kleinere, specifieke datasets, waardoor ze echte specialisten zijn voor bepaalde toepassingen.

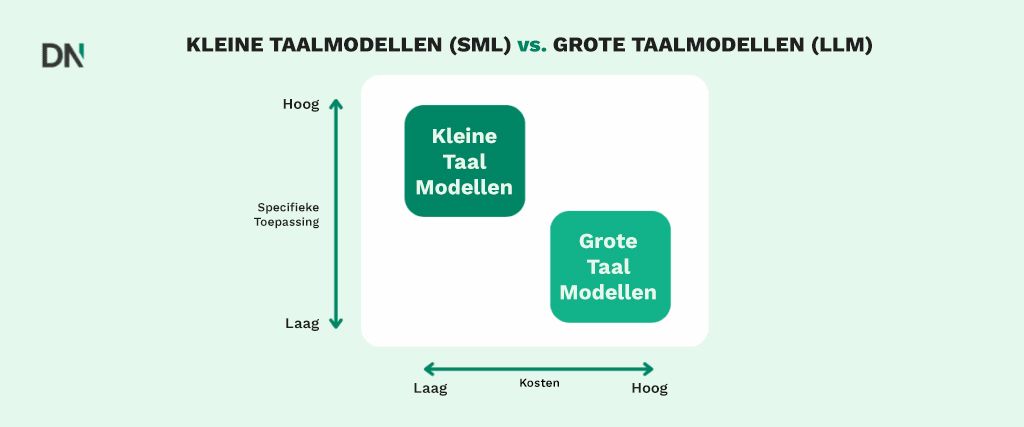

Klein taalmodel vs Groot Taalmodel

De verschillen tussen kleine taalmodellen en grote taalmodellen (LLM’s) zijn fundamenteel en bepalen hoe ze ingezet kunnen worden:

Grootte en complexiteit

LLM’s, zoals GPT-4, kunnen een overweldigend aantal parameters bevatten, soms wel 1,76 biljoen! Een open-source klein taalmodel als Mistral 7B heeft daarentegen ‘slechts’ zo’n 7,3 miljard parameters. Dit schaalverschil is niet zomaar een getal. Het bepaalt namelijk hoeveel rekenkracht nodig is en welke taken elk model aankan.

Training en middelen

Het trainen van LLM’s vereist gigantische datasets en enorme rekenkracht, vaak duizenden GPU’s. Dit brengt aanzienlijke infrastructuur- en operationele kosten met zich mee. Een klein taalmodel is veel minder veeleisend. Ze hebben minder rekenkracht, geheugen en opslag nodig, wat ze aanzienlijk goedkoper maakt om te trainen en te onderhouden.

Veelzijdigheid vs. specialisatie

LLM’s zijn gebouwd voor brede, algemene taken, met het doel menselijke intelligentie over een breed scala aan domeinen na te bootsen. De kracht ligt in hun veelzijdigheid. Kleine taalmodellen daarentegen zijn geoptimaliseerd voor precisie en efficiëntie binnen domein- specifieke taken. Deze focus stelt ze in staat uit te blinken waar nauwkeurigheid cruciaal is.

Inference snelheid

Door het kleinere aantal parameters kunnen kleine taalmodellen veel sneller reageren dan LLM’s, wat resulteert in een lagere latentie. LLM’s kunnen, vooral bij veel gelijktijdige gebruikers, tragere reactietijden hebben.

Vooroordeel

Kleine taalmodellen hebben een lager risico op vooroordelen vergeleken met LLM’s, omdat ze getraind zijn op kleinere, domein- specifieke datasets. LLM’s worden vaak getraind op enorme, ongefilterde internet data, die verkeerde- of onder- representaties kunnen bevatten, wat kan leiden tot potentiële vooroordelen.

Implementatie

Kleine taalmodellen zijn eenvoudiger te implementeren op diverse platforms, waaronder lokale machines, edge-apparaten en mobiele applicaties, vaak zonder de noodzaak van zware servers. LLM’s vereisen daarentegen doorgaans krachtige cloud servers om te kunnen functioneren.

Toepassingen voor kleine taalmodellen

Kleine taalmodellen blijken bijzonder effectief in gespecialiseerde sectoren:

Gezondheidszorg:

Kleine taalmodellen kunnen worden aangepast voor medische tekstanalyse, real-time gezondheidsmonitoring bieden en advies geven via wearables. Hun vermogen om zonder constante cloud verbinding te werken is cruciaal voor de privacy van patiënten.

Financiën

Deze modellen zijn uitstekend in het analyseren van resultaten en financieel nieuws voor aandelen voorspellingen, het beoordelen van leningsdocumentatie voor kredietscores en het detecteren van sentiment verschuivingen in markten.

Landbouw:

Kleine taalmodellen worden ontwikkeld om complexe agronomische vragen te beantwoorden en boeren te helpen bij het nemen van real-time beslissingen.

Juridisch:

Ze kunnen contractdocumenten analyseren om clausules te identificeren, potentiële risico’s te markeren en belangrijke data en financiële voorwaarden te extraheren voor compliance.

Marketing:

Kleine taalmodellen kunnen helpen bij het genereren van diverse marketingmaterialen, zoals social media posts, productbeschrijvingen en afbeeldingen.

Jouw volgende stap

Kleine taalmodellen (SLM’s) bieden een krachtige, toegankelijke en kosteneffectieve manier om AI te integreren in de kern van je bedrijf. Ze zorgen voor precisie waar het telt, verbeteren gegevensprivacy en maken real-time toepassingen mogelijk die de bedrijfsvoering en klantenservice van je organisatie kunnen transformeren.

Een succesvolle AI-implementatie begint met het begrijpen van je specifieke bedrijfsbehoeften en het identificeren van de juiste tools. Of je nu klantondersteuning wilt automatiseren, gegevensverwerking wilt stroomlijnen of innovatieve AI-oplossingen op apparaten wilt ontwikkelen, SLM’s bieden een aantrekkelijke en praktische kans. Het navigeren door modelselectie, finetuning en schaalbare implementatie kan uitdagend zijn.

Bij DataNorth kun je samenwerken met AI-experts om ervoor te zorgen dat jouw AI-initiatieven aansluiten bij jouw bedrijfsdoelstellingen en je rendement op investering maximaliseren.

Neem vandaag nog contact op met DataNorth en start jouw AI-reis!