Vectorisatie is een belangrijk onderdeel van moderne AI, waardoor machines alles kunnen verwerken: van tekst en afbeeldingen tot audio en video. In de kern zet vectorisatie complexe data om in reeksen getallen (arrays) die AI-systemen kunnen begrijpen en vergelijken. Zie het als het vertalen van menselijke informatie naar een wiskundige taal waarmee computers efficiënt kunnen werken.

Deze techniek stuurt veel AI-toepassingen aan die je dagelijks gebruikt. Wanneer Netflix series aanbeveelt die je misschien leuk vindt, wanneer Google begrijpt wat je zoekt zelfs als je niet precies de juiste woorden gebruikt, of wanneer je telefoon gezichten herkent in foto’s: op de achtergrond is vectorisatie aan het werk. In dit artikel duiken we in vectorisatie: wat het is, de verschillende soorten en wat het betekent voor toekomstige ontwikkelingen.

Wat is vectorisatie?

Vectorisatie transformeert verschillende typen data naar numerieke vector-representaties die machines efficiënt kunnen verwerken. In plaats van te werken met ruwe tekst, afbeeldingen of audio, werken AI-systemen met lijsten van getallen, genaamd vectoren. Elk stukje data wordt een punt in een multidimensionale ruimte, waar vergelijkbare items zich op natuurlijke wijze clusteren.

Stel je voor dat je boeken in een bibliotheek organiseert. In plaats van alleen te sorteren op auteur of titel, creëert vectorisatie een kaart waarop boeken over vergelijkbare onderwerpen dicht bij elkaar staan, zelfs als ze verschillende woorden gebruiken of door verschillende auteurs zijn geschreven. Deze numerieke representatie stelt AI in staat om wiskundige bewerkingen uit te voeren, zoals het berekenen van afstanden en overeenkomsten. Dit maakt het mogelijk om patronen te vinden, voorspellingen te doen en relaties te begrijpen tussen verschillende stukken informatie.

De kracht van vectorisatie ligt in het vermogen om betekenis vast te leggen. Wanneer je de woorden “blij” en “vrolijk” omzet in vectoren, belanden ze dicht bij elkaar in de wiskundige ruimte omdat ze vergelijkbare betekenissen hebben. Hetzelfde principe geldt voor afbeeldingen, waarbij foto’s van katten bij elkaar clusteren, zelfs als de katten er verschillend uitzien.

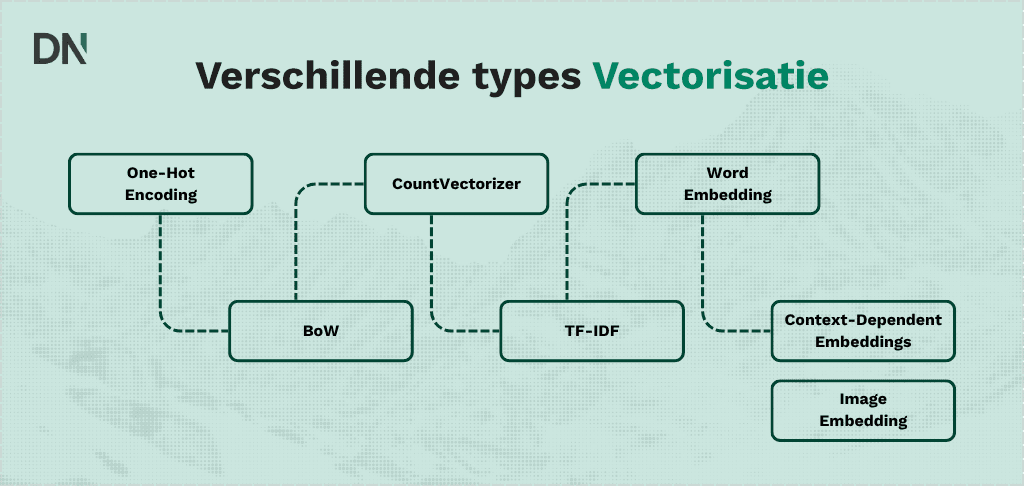

Verschillende typen vectorisatie

Vectorisatietechnieken verschillen aanzienlijk in hoe ze data representeren en welke informatie ze vastleggen. Het begrijpen van deze verschillende benaderingen is essentieel, omdat elke techniek specifieke sterke en zwakke punten heeft, afhankelijk van de toepassing.

One-hot encoding

One-hot encoding is de eenvoudigste vectorisatiemethode. Het zet elk woord om in een ‘sparse’ (ijle) binaire vector waarbij slechts één element “1” is en alle andere “0” zijn. Als je vocabulaire bijvoorbeeld “kat”, “hond” en “vogel” bevat, worden ze respectievelijk gerepresenteerd als [1, 0, 0], [0, 1, 0] en [0, 0, 1].

One-hot encoding is eenvoudig te implementeren en te begrijpen, wat het nuttig maakt voor kleinere datasets en eenvoudige toepassingen. Het wordt echter inefficiënt bij grote vocabulaires omdat de vectorgrootte groeit met het aantal unieke woorden. Een Engels woordenboek met tienduizenden woorden zou leiden tot enorme, grotendeels lege vectoren. Daarnaast behandelt one-hot encoding alle woorden als volledig onafhankelijk, waardoor semantische relaties tussen woorden ontbreken.

Bag of Words (BoW)

Bag of Words representeert een document als een verzameling woordfrequenties, waarbij een vector wordt gecreëerd waarin elke positie overeenkomt met een uniek woord in het vocabulaire. In plaats van de binaire aanpak van one-hot encoding, telt BoW hoe vaak elk woord voorkomt in een document.

Als je drie documenten hebt: “the cat in the hat”, “the cat sat on the mat” en “the dog chased the ball”, creëert Bag of Words vectoren die de woordaantallen voor elk document tonen. Document 1 zou [0, 1, 0, 0, 1, ...] kunnen zijn, waarbij de posities overeenkomen met woorden in je vocabulaire (alfabetisch: “ball”, “cat”, “chased”, “dog”, “hat”, etc.).

Bag of Words is een verbetering ten opzichte van one-hot encoding door informatie over woordfrequentie vast te leggen. Het negeert echter nog steeds de woordvolgorde en legt geen semantische relaties vast, waardoor “hond achtervolgde kat” hetzelfde wordt behandeld als “kat achtervolgde hond”. Door deze beperking kan belangrijke contextuele betekenis verloren gaan.

Count vectorization en hashing vectorization

Count-vectorisatie (CountVectorizer) is in wezen de Bag of Words-aanpak geïmplementeerd als een gestandaardiseerde tool. HashingVectorizer hanteert een vergelijkbare aanpak, maar gebruikt een hashing-functie in plaats van een vocabulaire op te slaan. Dit betekent dat HashingVectorizer het vocabulaire niet hoeft te onthouden, wat het geheugenefficiënter maakt voor zeer grote datasets.

De afweging is dat je met HashingVectorizer het oorspronkelijke woord niet kunt terughalen uit de vectorpositie, wat belangrijk is voor taken zoals trefwoordextractie. HashingVectorizer brengt ook het risico van “hash collisions” met zich mee, waarbij verschillende woorden per ongeluk naar dezelfde positie verwijzen, wat je data kan vertekenen. HashingVectorizer blinkt uit bij het verwerken van streaming data of datasets die te groot zijn voor het geheugen.

Term Frequency-Inverse Document Frequency (TF-IDF)

TF-IDF verbetert het basis-woordtellen door rekening te houden met hoe vaak een woord voorkomt in je gehele documentcollectie. Het kent hogere gewichten toe aan woorden die vaak voorkomen in een specifiek document, maar zelden in alle documenten. Woorden zoals “de” en “en” die overal voorkomen krijgen lagere gewichten, terwijl domeinspecifieke termen hogere gewichten krijgen.

Als je documenten over sport analyseert, krijgt het woord “basketbal” een hoge TF-IDF score in basketbalartikelen, maar een lage score in algemene documenten. Deze techniek is geavanceerder dan Bag of Words en legt een zekere mate van woordbelang vast, hoewel het nog steeds geen semantische betekenis of woordrelaties begrijpt.

Word embeddings

Word embeddings vertegenwoordigen een fundamentele verschuiving ten opzichte van frequentie-gebaseerde methoden. In plaats van grote, sparse vectoren te creëren waarbij de meeste waarden nul zijn, mappen embeddings woorden naar dense (dichte), lager-dimensionale vectoren waarbij elke dimensie latente kenmerken en semantische betekenis vastlegt.

Word2Vec, uitgebracht door Google-onderzoekers in 2013, bracht een revolutie teweeg in dit veld. In plaats van woordaantallen te gebruiken, leert Word2Vec dichte vector-representaties waarbij semantisch vergelijkbare woorden dicht bij elkaar eindigen in de vectorruimte. Het beroemde voorbeeld is dat vector-wiskunde werkt: koning min man plus vrouw is gelijk aan koningin, wat aantoont dat het model betekenisvolle relaties tussen concepten vastlegt.

In tegenstelling tot one-hot encoding, dat alle categorieën als onafhankelijk en equidistant behandelt, leggen embeddings relaties vast. “Kat” en “hond” zouden vergelijkbare vector-representaties hebben omdat het beide dieren zijn, terwijl “kat” en “auto” verder van elkaar verwijderd zouden zijn in de embedding-ruimte.

Context-dependent embeddings (Contextafhankelijke embeddings)

Eerdere benaderingen zoals Word2Vec creëren statische embeddings waarbij hetzelfde woord dezelfde vector-representatie krijgt, ongeacht de context. Recentere benaderingen zoals BERT hebben dit gerevolutioneerd door contextafhankelijke embeddings te creëren, waarbij hetzelfde woord verschillende vector-representaties krijgt afhankelijk van de omliggende context. BERT verwerkt woorden in twee richtingen (bidirectioneel) en houdt rekening met zowel de linker- als rechtercontext om embeddings te genereren die rijke contextuele informatie bevatten. Het woord “bank” krijgt verschillende embeddings in “financiële bank” versus “zitbank” omdat het model de omliggende context begrijpt.

Moderne Large Language Models (LLM’s) hebben deze mogelijkheden nog verder uitgebreid. OpenAI’s GPT-4 en ChatGPT gebruiken geavanceerde transformer-architecturen die zeer verfijnde embeddings creëren die genuanceerde semantische relaties vastleggen. OpenAI biedt gespecialiseerde embedding-modellen zoals text-embedding-3-small en text-embedding-3-large, die dichte vector-representaties produceren die geoptimaliseerd zijn voor verschillende use cases. De “small” versie creëert 1.536-dimensionale vectoren die geschikt zijn voor de meeste toepassingen, terwijl de “large” versie nog rijkere 3.072-dimensionale embeddings genereert voor taken die maximale semantische precisie vereisen.

Deze moderne embedding-modellen blinken uit in het begrijpen van context, het verwerken van meerdere talen en het vastleggen van subtiele betekenisverschillen die eerdere modellen misten. Ze zijn getraind op aanzienlijk grotere datasets en gebruiken geavanceerdere architecturen dan BERT, wat resulteert in embeddings die semantische relaties beter representeren over diverse domeinen en talen heen.

Hoewel deze modellen doorgaans embeddings van zeer hoge kwaliteit produceren, vereisen ze meer rekenkracht voor training en inference in vergelijking met eenvoudigere methoden. Ze vertegenwoordigen echter de huidige state-of-the-art in het vastleggen van semantische betekenis en worden gebruikt door de meeste moderne AI-systemen voor taken variërend van zoeken en aanbevelingen tot vraagbeantwoording en contentgeneratie.

Image embeddings

Vectorisatie reikt verder dan tekst. Image embeddings transformeren afbeeldingen naar numerieke representaties die betekenisvolle kenmerken vastleggen in een compacte vorm. Convolutionele neurale netwerken extraheren visuele kenmerken op meerdere abstractieniveaus, van eenvoudige randdetectie tot complexe objectherkenning.

Een afbeelding van een kat kan worden gerepresenteerd als een vector waarbij specifieke dimensies activeren voor “harig”, “vier poten”, “puntige oren” en “katachtig”. Hierdoor kan het systeem katten herkennen, zelfs als ze er anders uitzien dan de trainingsvoorbeelden. Deze aanpak maakt image search, objectherkenning en visuele gelijkenistoepassingen mogelijk.

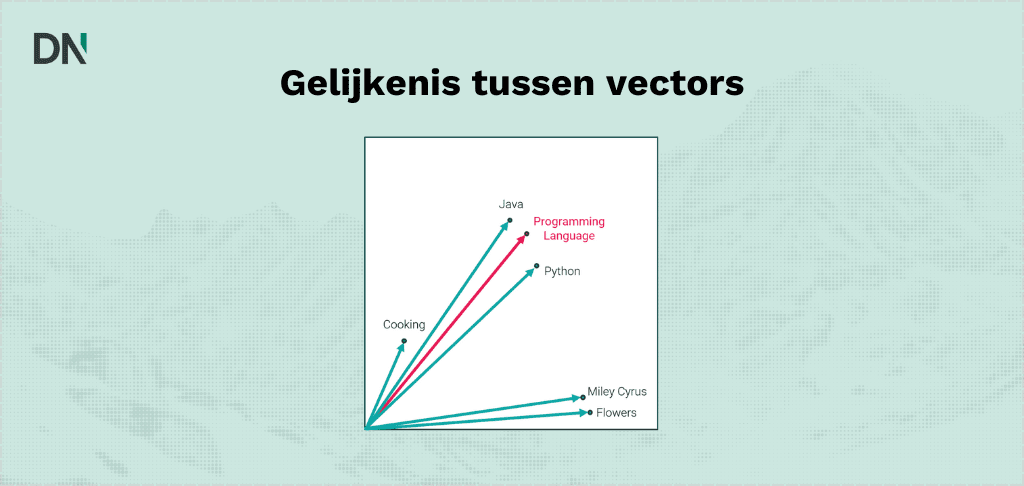

Meten van gelijkenis tussen vectoren

Zodra data vectoren zijn geworden, hebben AI-systemen manieren nodig om ze te vergelijken. Cosine similarity is een van de populairste methoden. Het meet de hoek tussen twee vectoren, met resultaten variërend van -1 (volledig tegenovergesteld) tot 1 (identiek). De schoonheid van cosine similarity is dat het focust op richting in plaats van lengte, wat het perfect maakt voor het vergelijken van betekenissen ongeacht documentgrootte.

Stel je twee pijlen voor die in de ruimte wijzen. Als ze in bijna dezelfde richting wijzen, zijn ze vergelijkbaar, zelfs als één pijl langer is. Dit werkt perfect voor semantisch zoeken, omdat een kort document en een lang document over hetzelfde onderwerp als vergelijkbaar beschouwd moeten worden, en cosine similarity bereikt dit op natuurlijke wijze.

Andere statistieken zoals Euclidische afstand meten de afstand in een rechte lijn tussen vectoren. Elke metriek heeft zijn sterke punten afhankelijk van de toepassing, maar cosine similarity is de standaard geworden voor de meeste tekst- en semantische toepassingen omdat het vastlegt wat mensen bedoelen met “vergelijkbare betekenis”.

Hoe wordt vectorisatie gebruikt?

Moderne AI-platforms leunen zwaar op vectorisatie om hun kernfunctionaliteit te leveren. Begrijpen hoe de systemen waarmee je dagelijks communiceert deze technologie implementeren, onthult waarom vectorisatie zo fundamenteel is geworden.

Vectorisatie in ChatGPT en taalmodellen

ChatGPT gebruikt vector-embeddings door zijn hele architectuur heen om tekst te begrijpen en te genereren. Wanneer je een vraag typt, zet het systeem je woorden om in hoog-dimensionale vectoren die semantische betekenis vastleggen. Deze embeddings stellen ChatGPT in staat om context te begrijpen, overeenkomsten tussen concepten te detecteren en antwoorden te genereren die aansluiten bij je intentie. Het model verwerkt tekst door woorden en zinnen te mappen naar vectoren in een hoog-dimensionale ruimte, waar semantische relaties wiskundige afstanden worden. Dit is waarom ChatGPT kan begrijpen dat “arts” en “dokter” in essentie hetzelfde betekenen, of waarom het herkent wanneer je een vervolgvraag stelt, zelfs als je andere bewoordingen gebruikt. Vector-embeddings vormen de brug tussen ruwe tekst en het geavanceerde taalbegrip dat conversationele AI mogelijk maakt.

Vectorisatie in Claude en Retrieval Augmented Generation (RAG)

Claude maakt uitgebreid gebruik van vectorisatie in Retrieval Augmented Generation (RAG) systemen. Wanneer je Claude een vraag stelt over specifieke documenten, zet het systeem die documenten eerst om in vector-embeddings en slaat ze op in een vector-database. Je vraag wordt ook omgezet in een vector, en het systeem vindt de semantisch meest vergelijkbare documentfragmenten (chunks) door vectoren te vergelijken. Anthropic heeft “Contextual Retrieval” methoden ontwikkeld die de prestaties van deze systemen drastisch verbeteren bij het vinden van relevante informatie. Deze aanpak vermindert mislukte zoekopdrachten met 49% vergeleken met traditionele methoden. Het systeem zet elk documentfragment om in contextuele embeddings die de betekenis behouden, zelfs wanneer tekst wordt gescheiden van de omliggende context, wat leidt tot nauwkeurigere retrieval en nuttigere antwoorden.

Vectorisatie in Google Search en semantisch begrip

Google Search gebruikt vector-embeddings om zijn semantische zoekcapaciteiten aan te drijven. Wanneer je naar iets zoekt, matcht Google niet langer alleen trefwoorden. In plaats daarvan zet het je zoekopdracht om in vectoren en vergelijkt deze met vector-representaties van miljarden webpagina’s. Dit stelt Google in staat om zoekintentie te begrijpen en resultaten te retourneren die overeenkomen met wat je bedoelt, niet alleen met wat je typte.

De Vertex AI Vector Search technologie van het bedrijf verwerkt enorme datasets met behulp van hetzelfde onderzoek dat kernproducten van Google zoals YouTube en Google Play aandrijft. Door zoekopdrachten en documenten in dezelfde vectorruimte te representeren, kan Google semantisch relevante resultaten vinden, zelfs wanneer de exacte woorden niet overeenkomen.

Vectorisatie in Spotify’s muziekaanbevelingen

Spotify gebruikt vector-embeddings en matrix-factorisatie om zijn recommendation engine aan te drijven. Het platform creëert vector-representaties voor zowel gebruikers als nummers, waarbij de vector van elke gebruiker hun muzieksmaak vastlegt en de vector van elk nummer de kenmerken ervan representeert. Nummers die gebruikers vaak samen afspelen of aan vergelijkbare playlists toevoegen, krijgen vergelijkbare vector-representaties. Het systeem ontleedt gebruiker-nummer interacties in lager-dimensionale vectoren, waardoor een latente “smaakruimte” ontstaat waarin gebruikersvoorkeuren en nummereigenschappen wiskundig vergeleken kunnen worden. Wanneer jouw gebruikersvector een hoge gelijkenis vertoont met de vector van een nummer, voorspelt Spotify dat je dat nummer leuk zult vinden. Deze aanpak helpt het platform verborgen pareltjes te ontdekken en gepersonaliseerde playlists zoals Discover Weekly te creëren die bijna griezelig nauwkeurig aanvoelen.

Vectorisatie in Netflix’ content aanbevelingen

Netflix zet vector-embeddings in als onderdeel van zijn geavanceerde aanbevelingssysteem. Het platform heeft een “Foundation Model for Personalized Recommendation” ontwikkeld dat grootschalige data benut om gebruiker- en content-embeddings te creëren. Deze vector-representaties leggen alles vast: van kijkgeschiedenis en voorkeuren tot contentkenmerken en contextuele factoren zoals het tijdstip van de dag. Het systeem van Netflix genereert embeddings die diverse downstream-applicaties mogelijk maken, van directe voorspellende modellen tot fine-tuned aanbevelingen voor specifieke contexten. De aanpak is zo effectief gebleken dat meer dan 80% van wat mensen op Netflix kijken voortkomt uit de aanbevelingen. Door continu te leren van gebruikersinteracties en vector-representaties bij te werken, levert het systeem steeds persoonlijkere ervaringen.

Vector-databases en efficiënte opslag

Het beheren van miljarden vectoren vereist gespecialiseerde infrastructuur. Vector-databases zoals Pinecone en Weaviate slaan embeddings efficiënt op en halen ze op, waardoor applicaties vergelijkbare items in milliseconden kunnen vinden. Deze databases gebruiken geavanceerde indexeringsmethoden die vectoren zo organiseren dat zoekopdrachten niet elk afzonderlijk item hoeven te vergelijken.

Traditionele databases zijn uitstekend in exact matching, maar vector-databases blinken uit in similarity searches. Wanneer je vraagt om “vergelijkbare items te vinden”, gebruiken ze approximate nearest neighbor algoritmen die een klein beetje nauwkeurigheid inruilen voor enorme snelheidsverbeteringen. In plaats van alle miljoen vectoren in je database te controleren, checken deze algoritmen misschien slechts 10.000 zorgvuldig geselecteerde kandidaten en vinden ze nog steeds in 95% van de gevallen het juiste antwoord.

Deze efficiëntie maakt real-time applicaties mogelijk. Of je nu door miljoenen documenten zoekt, vergelijkbare producten in een enorme catalogus vindt, of een chatbot aandrijft die direct relevante informatie moet ophalen: vector-databases bieden de snelheid en schaal die moderne AI vereist.

De toekomst van Vectorisatie

Vectorisatie blijft zich snel ontwikkelen. Nieuwe modellen creëren betere embeddings die betekenis nauwkeuriger vastleggen. Multimodale systemen kunnen nu tekst, afbeeldingen en audio in dezelfde vectorruimte embedden, wat applicaties mogelijk maakt die over verschillende datatypen heen werken. Zoek naar een afbeelding met behulp van tekst, of vind vergelijkbare muziek door een melodie te neuriën.

Efficiëntieverbeteringen maken vectorisatie praktisch voor meer toepassingen. Betere compressietechnieken verlagen de opslagkosten met behoud van kwaliteit. Snellere zoekalgoritmen maken real-time verwerking van enorme datasets mogelijk. Gespecialiseerde hardware versnelt vector-operaties, waardoor complexe berekeningen mogelijk worden op edge devices.

Naarmate AI geavanceerder wordt, blijft vectorisatie fundamenteel. Het is de brug die menselijke informatie verbindt met machineverwerking, waardoor computers betekenis kunnen begrijpen in plaats van alleen symbolen te manipuleren. Of je nu zoekmachines, aanbevelingssystemen of conversationele AI bouwt: het begrijpen van vectorisatie is essentieel voor het creëren van effectieve moderne applicaties.

Vectorisatie door DataNorth AI

Bij DataNorth AI benutten we vectorisatie om intelligente oplossingen in diverse industrieën aan te drijven. Onze AI Strategie consultancy helpt organisaties identificeren waar geavanceerde retrieval-systemen voordelen kunnen ontsluiten. We hebben op vectoren gebaseerd documentbegrip geïmplementeerd in onze Knowledge Base-oplossing, wat naadloze verwerking van geüploade documenten mogelijk maakt via intelligente embeddings. Hierdoor wordt ongestructureerde data getransformeerd in bruikbare inzichten. Deze zelfde aanpak kan op maat worden gemaakt in Custom AI Development voor jouw specifieke uitdagingen, of je nu zoekfunctionaliteit optimaliseert, recommendation engines bouwt of intelligente documentbeheersystemen creëert. Neem contact op met de AI experts van DataNorth AI om te ontdekken hoe vectorisatie jouw bedrijf kan transformeren.