Waardevolle inzichten uit je data halen kan lastig zijn en begint vaak met een cruciale stap: het voorbereiden van je data, ook wel ‘Data Preprocessing’ genoemd. Data voorbereiding legt de basis voor succesvolle analyses en besluitvorming door Machine Learning. Door ruwe data te reinigen, te transformeren en te organiseren, wordt het een waardevol hulpmiddel dat nauwkeurige en effectieve bedrijfsstrategieën mogelijk maakt.

Maar wat is data preprocessing precies? Het is simpelweg het proces van het verzamelen, opschonen en structureren van data om de kwaliteit, consistentie en relevantie te waarborgen. Dit proces helpt bedrijven het volledige potentieel van hun data te benutten door overbodigheden, fouten en inconsistenties te verwijderen, wat resulteert in een opgeruimde en samenhangende dataset die klaar is voor analyse.

In dit blog bespreken we het proces van data voorbereiding, de rol ervan in machine learning, en verschillende methoden en use cases. Of je nu een ervaren datawetenschapper bent of nieuw bent in de analyse van data, dit artikel helpt je om het potentieel van je data te benutten en datagedreven succes voor je organisatie te behalen.

Laten we beginnen met te begrijpen waarom data voorbereiding zo belangrijk is!

Waarom is data preprocessing belangrijk?

Data preprocessing is belangrijk om twee redenen: het verbeteren van de kwaliteit van data en het makkelijker maken van gegevensintegratie.

Kwaliteit van data: Grote datasets verzameld uit verschillende bronnen kunnen fouten, inconsistenties en ontbrekende waarden bevatten. Door deze afwijkingen op te schonen, kunnen organisaties ervoor zorgen dat hun analyse is gebaseerd op betrouwbare en nauwkeurige gegevens.

Gegevensintegratie: Organisaties hebben vaak gegevens opgeslagen in verschillende formaten en systemen. Gegevensvoorbereiding maakt integratie van uiteenlopende gegevensbronnen mogelijk, waardoor een volledig overzicht van het bedrijf ontstaat. Dit helpt bij betere analyses en een holistisch begrip van de bedrijfsvoering, klanten en markttrends.

Gegevensvoorbereiding is vooral belangrijk bij grote datasets. Bij grote hoeveelheden data zijn er meer uitdagingen. Er kunnen vaker fouten en inconsistenties zijn, en de data kan te complex zijn om direct te analyseren. Door data voor te bereiden, kunnen organisaties het analyseproces eenvoudiger en efficiënter maken. Dit bespaart tijd en middelen, en zorgt voor snellere inzichten en besluitvorming.

Verder is gegevensvoorbereiding ook nodig bij ongestructureerde of semi-gestructureerde data. Voorbeelden hiervan zijn sociale media, sensorgegevens en tekstgebaseerde inhoud. Organisaties hebben toegang tot veel ongestructureerde data, maar deze moet worden verwerkt en georganiseerd om waardevolle inzichten te verkrijgen. Technieken zoals tekstparsing, sentimentanalyse en entiteitherkenning helpen om ongestructureerde data om te zetten in gestructureerde formaten voor analyse.

Gegevensvoorbereiding is ook belangrijk voor naleving van regelgeving. Veel sectoren, zoals financiën en gezondheidszorg, hebben strikte regels voor gegevensprivacy en -beveiliging. Door data voor te bereiden en ervoor te zorgen dat deze voldoet aan de regels, kunnen organisaties juridische en reputatierisico’s vermijden.

Nu we het belang van gegevensvoorbereiding, ook bekend als data preprocessing, en de relevantie ervan voor grote datasets begrijpen, laten we eens kijken naar het proces zelf en hoe gegevensvoorbereiding wordt uitgevoerd.

Hoe ziet het proces van data preprocessing eruit?

In een proces om data voor te bereiden is elke stap belangrijk om de kwaliteit, betrouwbaarheid en bruikbaarheid van de data te garanderen voor analyse en besluitvorming. Door deze stappen te volgen, kunnen organisaties hun data effectief voorbereiden voor nauwkeurige inzichten en weloverwogen beslissingen.

- Data verkrijgen

- Data verkennen

- Data opschonen

- Data transformeren

Laten we elke stap eens van dichtbij bekijken!

Data verkrijgen

De eerste stap in data preprocessing is het verzamelen van de benodigde data. Dit houdt in het vinden van relevante gegevensbronnen, zoals databases, API’s, bestanden of webscraping, en het ophalen van de gegevens uit deze bronnen. Het is belangrijk om uitgebreide en nauwkeurige data te verzamelen die aansluiten bij de doelstellingen van de analyse of het project. Een goede gegevensverzameling vormt de basis voor de volgende stappen.

Data verkennen

Nadat de gegevens zijn verzameld, is de volgende stap om ze te verkennen. Gegevensverkenning houdt in dat je de structuur en inhoud van de gegevens begrijpt om inzichten te verkrijgen en eventuele problemen of patronen te identificeren. Dit proces bestaat uit taken zoals het onderzoeken van de statistische eigenschappen van de gegevens, het visualiseren ervan met grafieken of diagrammen, en het uitvoeren van een voorlopige analyse.

Het verkennen van de gegevens helpt bij het identificeren van ontbrekende waarden, uitschieters, inconsistenties of andere problemen met de gegevenskwaliteit die moeten worden opgelost voordat verdere analyse kan plaatsvinden.

Data opschonen

Het opschonen van de data is een cruciale stap om de kwaliteit en betrouwbaarheid ervan te waarborgen. Het opschonen van data houdt in dat je fouten, inconsistenties en onnauwkeurigheden in de dataset identificeert en corrigeert. Dit proces bestaat uit het behandelen van ontbrekende waarden, het verwijderen van duplicaten, het standaardiseren van formaten en het oplossen van discrepanties. Door de data op te schonen, kunnen analisten ervoor zorgen dat ze consistent, nauwkeurig en betrouwbaar zijn, waardoor het risico op misleidende of bevooroordeelde analyses wordt geminimaliseerd.

Data transformeren

Bij het transformeren van gegevens worden ruwe gegevens omgezet in een formaat dat geschikt is voor analyse of verwerking. Deze stap houdt vaak in dat de data wordt gemanipuleerd om nieuwe variabelen te creëren, gegevens te aggregeren of samen te vatten, of berekeningen uit te voeren.

Transformatietechnieken kunnen onder meer datanormalisatie, schaalvergroting, het coderen van categorische variabelen of het toepassen van wiskundige en statistische bewerkingen omvatten. Door de gegevens te transformeren, kunnen analisten de bruikbaarheid, compatibiliteit en relevantie ervan voor de specifieke analyse of toepassing verbeteren.

In conclusie, een goed uitgevoerd gegevens voorbereidingsproces is essentieel voor organisaties om waardevolle inzichten uit hun gegevens te halen. Door relevante gegevens te verkrijgen, de kenmerken ervan te verkennen, fouten en inconsistenties op te schonen en ze om te zetten in een geschikt formaat, kunnen organisaties de betrouwbaarheid en kwaliteit van hun gegevens waarborgen.

Nu zullen we specifiek in gaan op gegevensvoorbereiding voor machine learning. Dus blijf lezen!

Gegevensvoorbereiding voor machine learning

In machine learning is de voorbereiding van data heel belangrijk voor het succes en de nauwkeurigheid van je modellen. Door je data zorgvuldig te verzamelen en te bewerken, kun je biases verminderen, ontbrekende waarden aanpakken en de selectie van kenmerken optimaliseren. Dit zorgt voor betrouwbaardere en effectievere machine learning modellen.

We zullen dieper ingaan op de specifieke aspecten van data voorbereiding die belangrijk zijn voor machine learning, waaronder:

- Omgaan met ontbrekende data

- Schalen en normaliseren van kenmerken

- Coderen van categorische variabelen

- Omgaan met uitschieters

- Selectie van kenmerken en verminderen van dimensies

- Omgaan met klasse-ongelijkheid

Omgaan met ontbrekende data

Bij ontbrekende waarden zijn er verschillende manieren om ervoor te zorgen dat je model goed blijft werken. Een manier is om alle gevallen met ontbrekende data te verwijderen, maar dit kan veel waardevolle informatie kosten.

Een andere manier is om ontbrekende waarden in te vullen door hun waarden te schatten met statistische methoden, zoals het gemiddelde of de mediaan, of meer geavanceerde technieken zoals regressie-imputatie of meerdere imputaties. Welke methode je kiest, hangt af van de aard en verdeling van de ontbrekende data en de kenmerken van de dataset.

Schalen en normaliseren van kenmerken

Kenmerkschaalvergroting en normalisatie zijn belangrijk bij het voorbereiden van data voor machine learning. Deze technieken zorgen ervoor dat alle kenmerken op dezelfde schaal zitten, zodat variabelen met grotere waarden niet gaan overheersen. Schaalmethoden zoals standaardisatie zorgen voor een gemiddelde van nul en een standaardafwijking van één, terwijl normalisatietechnieken zoals min-max-scaling kenmerken naar een specifiek bereik brengen.

Coderen van categorische variabelen

Bij de voorbereiding van data voor machine learning moeten categorische variabelen (die kwalitatieve gegevens vertegenwoordigen) worden omgezet in numerieke waarden die algoritmen kunnen begrijpen.

Er zijn twee veelgebruikte methoden hiervoor: one-hot encoding en label encoding. One-hot encoding maakt binaire vectoren, waarbij elk element aangeeft of een specifieke categorie aanwezig is of niet. Label encoding wijst unieke numerieke waarden toe aan elke categorie.

Omgaan met uitschieters

Uitschieters zijn datapunten die sterk afwijken van de rest van de dataset en een grote invloed kunnen hebben op modeltraining en voorspellingen. Er zijn verschillende manieren om met uitschieters om te gaan. Eén manier is om ze uit de dataset te verwijderen als ze foutief lijken of onwaarschijnlijk in reële situaties.

Een andere manier is om uitschieters te vervangen of in te vullen met technieken zoals gemiddelde, mediaan of regressie-imputatie. Je kunt ook de kenmerken ruimte transformeren, bijvoorbeeld door logaritmische of machtsomzettingen te gebruiken, om de invloed van extreme waarden te verminderen.

Selectie van kenmerken en verminderen dimensies

Het selecteren gebaseerd op kenmerken helpt bij het vinden van de belangrijkste kenmerken voor nauwkeurige voorspellingen, terwijl het verminderen van dimensies het aantal kenmerken verkleint en toch de meest relevante informatie behoudt. Deze technieken verbeteren de prestaties van het model, maken het model beter te begrijpen en zorgen voor efficiëntere berekeningen door zich te richten op de belangrijkste kenmerken en het verminderen van de complexiteit van de dataset.

Omgaan met klasse-ongelijkheid

Klasse-ongelijkheden ontstaan wanneer de verdeling van voorbeelden over verschillende klassen ongelijk is, waarbij één of meer klassen veel minder vertegenwoordigd zijn. Dit kan leiden tot bevoordeelde modellen die slecht presteren op de minderheidsklassen. Er zijn verschillende manieren om klasse-ongelijkheden aan te pakken, zoals hersamplingmethoden zoals het oversamplen van de minderheidsklasse of het ondersamplen van de meerderheidsklasse.

Daarnaast kunnen algoritmische benaderingen zoals kosten-sensitief leren of ensemble-methoden worden gebruikt om tijdens het modeltraining meer aandacht te geven aan de minderheidsklasse. Om het meeste uit je machine learning-model te halen, lees verder om verschillende methoden voor gegevensvoorbereiding te ontdekken, waaronder veelgebruikte tools en effectieve strategieën.

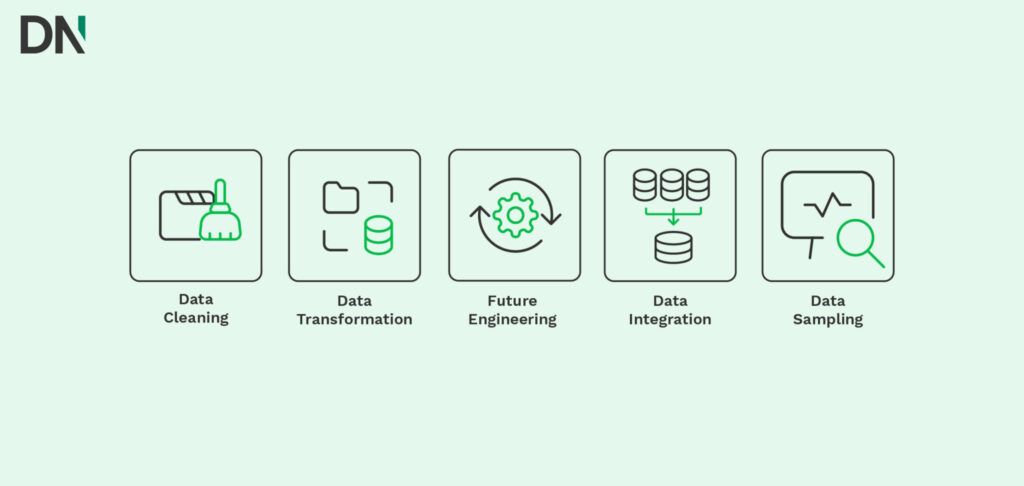

Data preparatie methoden

Bij het kiezen van de juiste tool of strategie begrijpen we dat de overvloed aan opties overweldigend kan zijn. Met zoveel keuzes beschikbaar, kan het moeilijk zijn om een beslissing te nemen. Om je te helpen bij dit proces, hebben we een beknopt overzicht gemaakt van tools en strategieën voor de volgende aspecten:

- Data opschonen

- Data transformeren

- Feature engineering

- Data integratie

- Data sampling

Data opschonen

Er zijn verschillende methoden en tools beschikbaar voor deze taak. Een veelgebruikte techniek is imputatie, waarbij ontbrekende waarden worden ingevuld met statistische methoden zoals het gemiddelde, de mediaan of regressie-imputatie. Tools zoals Pandas, een krachtige Python-library, bieden functies voor het efficiënt invullen van ontbrekende waarden.

Daarnaast kunnen methoden voor het detecteren van uitschieters, zoals het gebruik van z-scores of clustering, afwijkende gegevenspunten identificeren en verwerken die de analyse kunnen verstoren.

Data transformeren

Een populaire transformatietechniek is normalisatie, waarbij numerieke gegevens worden geschaald naar een standaardbereik, vaak tussen 0 en 1, zodat alle variabelen gelijk bijdragen aan de analyse. Standaardisatie is een andere methode die de gegevens aanpast zodat ze een gemiddelde van nul en een standaarddeviatie van één hebben. Beide technieken worden vaak gebruikt in machine learning. Libraries zoals Scikit-learn bieden gebruiksvriendelijke functies voor deze transformaties.

Feature engineering

Feature engineering is het proces van het creëren van nieuwe kenmerken of het aanpassen van bestaande om de voorspellende kracht van machine learning-modellen te verbeteren. Dit kan bestaan uit het afleiden van nieuwe variabelen uit bestaande, het coderen van categorische variabelen of het creëren van interactietermen.

Feature engineering vereist een combinatie van domeinkennis, creativiteit en statistische technieken. Tools zoals TensorFlow en PyTorch bieden libraries voor kenmerk extractie en -transformatie, waardoor deze methoden efficiënt kunnen worden geïmplementeerd.

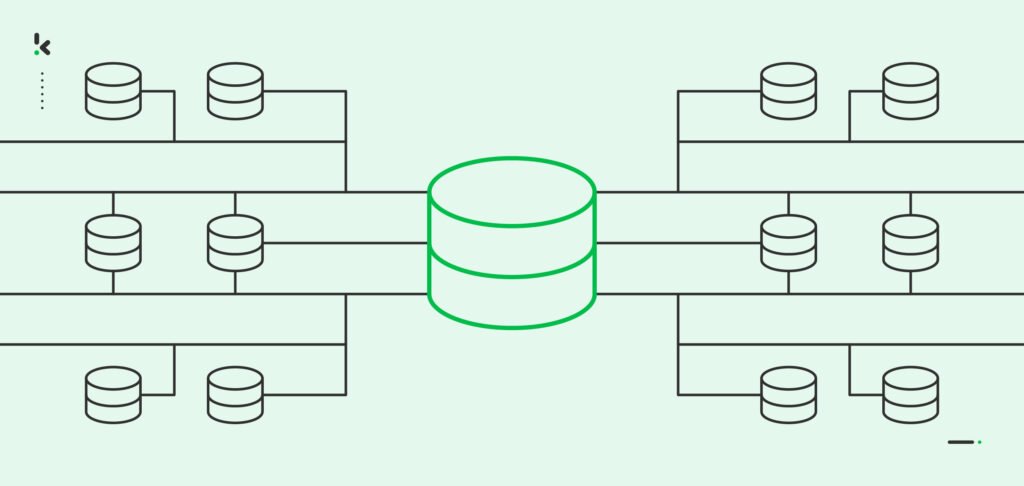

Data integratie

Gegevensintegratie houdt in het combineren van gegevens uit meerdere bronnen, vaak in verschillende formaten of structuren. Dit proces is essentieel voor het creëren van een uitgebreide dataset voor analyse. Verschillende tools en strategieën kunnen helpen bij gegevensintegratie. ETL-tools zoals Apache Spark en Talend vergemakkelijken de extractie en transformatie van gegevens uit verschillende bronnen.

Daarnaast bieden platforms zoals Informatica en IBM InfoSphere uitgebreide oplossingen voor het integreren en harmoniseren van gegevens uit verschillende systemen en formaten.

Data Sampling

Data sampling is een techniek om een subset van gegevens uit een grotere dataset te selecteren voor analyse. Dit is vooral nuttig bij grote datasets of onevenwichtige klassen. Veelgebruikte strategieën zijn onder andere willekeurige sampling, gestratificeerde sampling en oversampling. Tools zoals Scikit-learn en de caret-package van R bieden functies voor het implementeren van deze technieken.

Als je nog steeds onzeker bent of niet over de middelen beschikt voor data preprocessing, maak je dan geen zorgen. Experts, zoals die van Klippa DataNorth, zijn gespecialiseerd in gegevensvoorbereiding en kan je helpen met jouw behoeften.

Consulting voor Data Preparatie

Bij DataNorth weten we dat effectieve gegevensvoorbereiding, ook wel Data Preprocessing, de sleutel is tot het benutten van de volledige waarde van data. Daarom bieden we consulting aan om organisaties te helpen hun data klaar te maken voor succes. Met onze expertise en geavanceerde oplossingen kunnen we jouw organisatie helpen waardevolle inzichten te verkrijgen en data gedreven beslissingen met vertrouwen te nemen.

Als je vragen hebt of meer wilt weten over onze diensten, neem dan gerust contact met ons op. Ons team van experts staat klaar om je te helpen je data te optimaliseren en je bedrijfsdoelen te bereiken.