Grote taalmodellen hebben onze interactie met technologie ingrijpend veranderd: computers zijn nu in staat om tekst te begrijpen en te genereren die bijna niet van menselijke communicatie te onderscheiden is.

Misschien denk je dat het ontwikkelen van een eigen LLM-applicatie alleen is weggelegd voor grote bedrijven met veel middelen. In werkelijkheid is het bouwen van een applicatie met behulp van een LLM tegenwoordig veel toegankelijker, zelfs voor beginners. Het trainen van een LLM vanaf nul vraagt inderdaad om enorme hoeveelheden resources, maar dat is meestal niet nodig.

Voor de meeste geavanceerde toepassingen hoef je het model niet zelf vanaf het begin te trainen. Het is vaak veel praktischer en efficiënter om gebruik te maken van bestaande, vooraf getrainde modellen, of deze licht aan te passen aan jouw specifieke wensen.

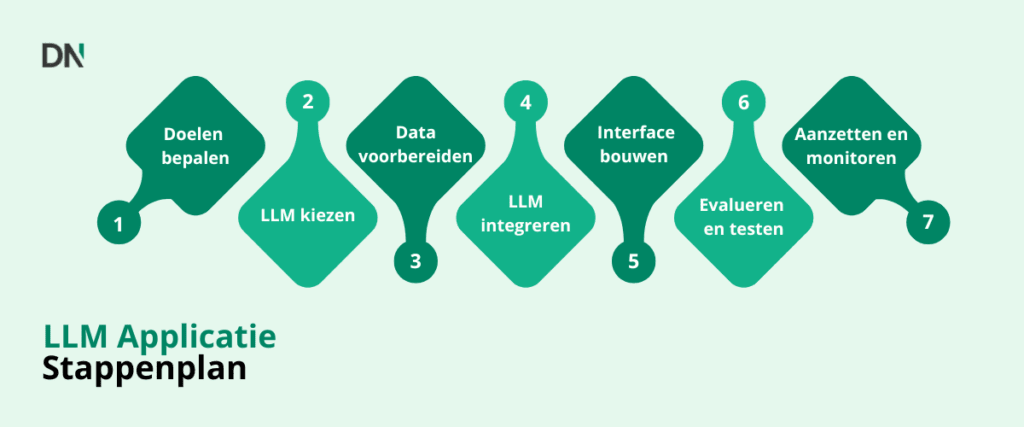

Stap 1: Bepaal je doelen en gebruikstoepassing

De eerste stap is helder krijgen wat je wilt dat jouw LLM (Large Language Model) gaat doen. Wat is het doel van je applicatie? Welke complexe taken moet het model ondersteunen?

Het duidelijk formuleren van je doel heeft invloed op latere keuzes, zoals welk type LLM je nodig hebt en welke hoogwaardige data belangrijk zijn voor je toepassing.

Stap 2: Kies een LLM

Als je weet wat het doel van je applicatie is, heb je drie hoofdopties om deze te realiseren met een LLM:

- Gebruik een vooraf getraind model:

Dit is de eenvoudigste en meest kostenefficiënte keuze. Je maakt gebruik van een model dat al getraind is op een grote hoeveelheid algemene data en gebruikt het direct voor het uitvoeren van voorspellingen. Je hoeft zelf geen extra training uit te voeren, waardoor je minimale rekenkracht en data nodig hebt. - Gebruik een vooraf getraind model en pas het aan (fine-tunen):

Hierbij neem je een bestaand model en train je het verder op een kleinere, specifieke dataset die relevant is voor jouw toepassing. Fine-tuning zorgt ervoor dat het model beter presteert binnen een bepaald domein of voor een specifieke taak. Dit vraagt meer rekenkracht dan het direct gebruiken van een model, maar veel minder dan het trainen vanaf nul. - Train een model vanaf nul:

Dit wordt meestal afgeraden. Je bouwt en traint dan een LLM helemaal zelf, beginnend met willekeurige instellingen. Dit proces vereist enorme hoeveelheden rekenkracht en data en brengt veel risico’s met zich mee. In de praktijk wordt bijna altijd een bestaand model als basis gebruikt, omdat dit veel tijd en middelen bespaart.

Tip: Platforms zoals Hugging Face bieden een breed scala aan open source, vooraf getrainde modellen en tools om ze verder te trainen. Met bibliotheken als PyTorch en TensorFlow kun je eenvoudig werken met deze modellen en ze aanpassen aan jouw wensen.

Stap 3: Bereid je data voor

Afhankelijk van de gekozen LLM-aanpak is het belangrijk om aandacht te besteden aan de voorbereiding van je data.

- Bij fine-tuning: Verzamel een dataset die specifiek is voor jouw taak of domein. De kwaliteit van deze data is essentieel voor goede prestaties. Dit betekent dat je relevante teksten moet verzamelen, opschonen en eventueel formatteren of annoteren.

- Bij gebruik van vooraf getrainde modellen: Denk goed na over de invoerdata die jouw applicatie aan het LLM zal aanbieden. Deze data moet relevant en goed geformatteerd zijn, zodat het model de informatie optimaal kan verwerken.

Stap 4: Integreer de LLM

Nu je een LLM hebt gekozen of voorbereid, moet je deze koppelen aan je applicatie. Dit gebeurt meestal via een API.

Veel aanbieders van modellen leveren API’s waarmee je toegang krijgt tot hun LLM’s. Gebruik je een zelf gefinetuned open source model, dan zet je zelf een API-endpoint op om je model beschikbaar te maken. Bij vooraf getrainde modellen wordt het endpoint vaak door de aanbieder geleverd. Je applicatie stuurt verzoeken naar deze API en ontvangt de antwoorden van de LLM terug.

Stap 5: Bouw de gebruikersinterface

In deze stap ontwerp je de gebruikersinterface van je applicatie. Je bepaalt hoe gebruikers input geven aan de LLM en hoe de output wordt getoond.

Bijvoorbeeld: bouw je een chatbot, dan heb je een tekstveld nodig voor de gebruiker en een weergavegebied voor het gesprek. De applicatiecode zorgt ervoor dat de gebruikersinput naar de LLM wordt gestuurd via de API, het antwoord wordt opgehaald en vervolgens zichtbaar wordt gemaakt voor de gebruiker.

Stap 6: Evalueren en testen

Zodra je applicatie in elkaar zit, is het belangrijk om deze grondig te testen om zeker te weten dat de LLM doet wat je verwacht voor jouw specifieke toepassing.

Testen betekent dat je de applicatie uitprobeert met realistische invoer en controleert of de uitkomsten van de LLM accuraat, relevant en bruikbaar zijn. Voor domeinspecifieke toepassingen moet je de resultaten mogelijk beoordelen aan de hand van specifieke criteria voor dat vakgebied. Je kunt hiervoor evaluatie datasets gebruiken, of mensen inschakelen om de kwaliteit van de antwoorden te beoordelen, zeker bij open vragen.

Stap 7: Uitrollen en monitoren

De laatste stap is zorgen dat je applicatie beschikbaar is voor gebruikers en dat deze betrouwbaar blijft werken.

Uitrollen betekent dat je de applicatie en de LLM host op servers, vaak via cloudplatforms zoals AWS, Google Cloud of Azure, die schaalbare middelen bieden.

Het is belangrijk om je applicatie continu te monitoren, zodat je de prestaties en het gedrag van de LLM kunt volgen en eventuele problemen of onverwachte uitkomsten snel opmerkt. Door het model regelmatig bij te werken of opnieuw te trainen met nieuwe data, houd je de prestaties en relevantie op peil.

Uitdagingen bij het bouwen van een LLM

- Rekenkracht en kosten: Het gebruik van API’s en fine-tuning vraagt om rekenkracht, wat kosten met zich meebrengt, vooral op grote schaal.

- Dataprivacy: Als je applicatie gevoelige gegevens verwerkt, moet je ervoor zorgen dat de LLM en je applicatie voldoen aan privacywetgeving.

- Debuggen: Het model precies laten doen wat je wilt, vraagt soms om veel experimenteren, zeker bij fine-tuning of het optimaliseren van prompts.

Conclusie

Je hebt tegenwoordig geen groot team of diepgaande AI-kennis meer nodig om een LLM-applicatie te bouwen. Met duidelijke doelen, kwalitatieve data en de juiste tools kun je krachtige toepassingen ontwikkelen die profiteren van de mogelijkheden van moderne LLM’s.

Wil je je eigen LLM bouwen of deskundig advies bij dit proces? Neem dan gerust contact op met DataNorth AI!