Als je vaak met AI-onderwerpen te maken hebt, heb je waarschijnlijk al gehoord van tokenisatie. Afhankelijk van de context kan dit verwijzen naar databeveiliging, blockchain-assets of tekstanalyse. Vandaag richten we ons echter uitsluitend op tokenisatie binnen Large Language Models (LLM’s).

Wat is tokenisatie?

Tokenisatie betekent het opdelen van menselijke taal in kleinere, beter hanteerbare eenheden die “Tokens” worden genoemd.

Elke invoer die naar een LLM wordt gestuurd, moet eerst door een tokenizer gaan. De tokenizer splitst de invoer op in een reeks tokens door de woorden om te zetten in getallen, omdat LLM’s uitsluitend numerieke data kunnen verwerken.

Het tokenisatieproces

Er zijn drie kernstappen:

- Invoergegevens – Dit is de ruwe tekst die je wilt verwerken (deze stap gebeurt voordat de tekst naar het model wordt gestuurd). De aard van deze tekst bepaalt hoe deze in tokens moet worden opgedeeld.

- Transformers – Dit is de architectuur van het model die de getokeniseerde invoer verwerkt. Tokenisatie zorgt ervoor dat de invoer wordt omgezet naar het juiste formaat, zodat het model deze effectief kan verwerken.

- Voorspellende output – Het model genereert de voorspellingen, maar de kwaliteit van deze output wordt mede bepaald door hoe goed de invoer is getokeniseerd. Goede tokenisatie vangt de betekenis en structuur van de oorspronkelijke tekst, waardoor het model nauwkeurigere en samenhangendere antwoorden kan geven.

Vormen van tokenisatie

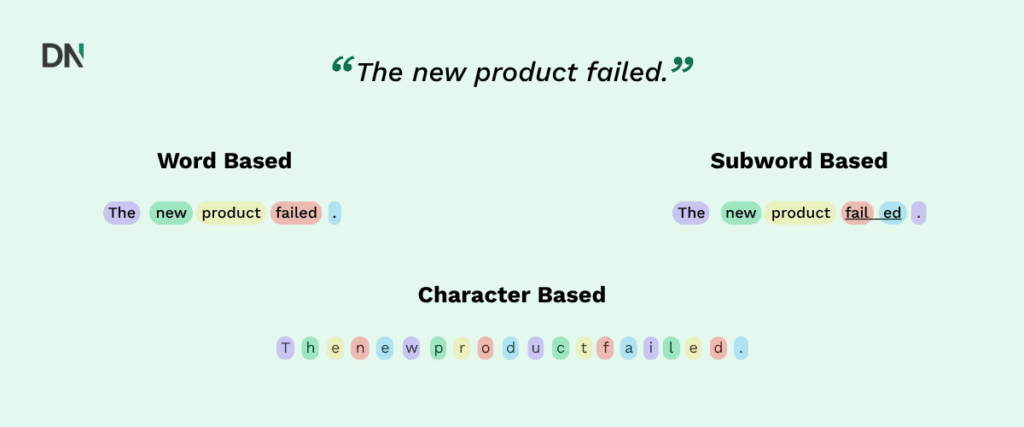

Er zijn drie hoofdmethoden om tekst te tokeniseren:

- Woord– gebaseerd: Elk woord wordt als een apart token behandeld.

- Karakter– gebaseerd: Elk afzonderlijk teken wordt een token.

- Subwoord– gebaseerd: Woorden worden opgesplitst in kleinere, betekenisvolle eenheden in plaats van volledige woorden of losse tekens.

Wat is een subwoord?

Subwoorden zijn kleinere, betekenisvolle delen van een woord.

Bijvoorbeeld: onverwerkt → on + verwerkt

Hierdoor kan het model variaties van woorden begrijpen en genereren die het misschien nog niet eerder heeft gezien. Dit is vooral belangrijk tijdens het trainen, zeker bij grote en diverse datasets.

Het is goed om te weten dat LLM’s vooral subwoord gebaseerde tokenisatie gebruiken, omdat dit een goede balans biedt tussen de omvang van de woordenschat en het begrip van de context.

Nadelen van woord gebaseerde tokenisatie

Herhaling van vergelijkbare woorden: LLM’s hebben moeite om verbanden te leggen tussen woorden met dezelfde stam. Bijvoorbeeld, “run”, “running” en “runner” worden als volledig aparte tokens gezien, zonder hun onderlinge relatie te herkennen.

Stopwoorden: Veelvoorkomende woorden zoals “en”, “of”, “de” en “is” voegen weinig betekenis toe aan zinnen, maar nemen toch ruimte in als token.

Out-of-vocabulary-problemen: Het model heeft moeite met woorden die het tijdens de training niet heeft gezien, vooral bij spelfouten of nieuwe termen.

Nadelen van karakter gebaseerde tokenisatie

Kleine woordenschat, lange reeksen: Hoewel karaktergebaseerde tokenisatie een kleine woordenschat heeft, zorgt het voor veel langere contexten, wat de verwerking inefficiënt maakt.

Gebrek aan betekenis: Losse karakters dragen op zichzelf geen betekenis, waardoor het voor modellen lastig is om context en relaties te begrijpen.

Verlies van taalstructuur: Deze methode vangt geen belangrijke patronen of woordstructuren op die essentieel zijn voor taalbegrip.

Hoe bepalen we waar we woorden splitsen?

Een veelgebruikte methode is Byte Pair Encoding (BPE). Hierbij worden veelvoorkomende karakter paren of subwoorden samengevoegd, waardoor het totale aantal tokens afneemt zonder dat er betekenis verloren gaat. Deze methode is efficiënt en wordt veel toegepast in natuurlijke taalverwerking.

Tokens en kosten

Zoals je inmiddels weet, hangt er een prijskaartje aan het gebruik van AI (zeker voor geavanceerde functies).

Tokenisatie heeft daarom direct invloed op de kosten van grote taalmodellen (LLM’s). In plaats van een vast bedrag per interactie, betaal je op basis van het aantal gebruikte tokens.

API-gebruikers krijgen meestal met twee soorten prijsstelling te maken:

- Invoerprijs: Kosten voor tokens in je prompts en vragen.

- Uitvoerprijs: Kosten voor tokens in het antwoord van het model.

Bedrijven tonen hun prijzen vaak per 1.000 tokens of per 1 miljoen tokens, zodat je een inschatting kunt maken van de kosten.

Token-efficiëntie (Hoeveel tokens voor dezelfde zin?)

Bijvoorbeeld, de zin: “Artificial intelligence is transforming the world.”

- GPT-4: 8 tokens

- Claude: 8 tokens (geschat)

- Mistral: 9 tokens

- LLaMA 3: 10 tokens

Pro tip: Je kunt tools zoals de tokenizer-pagina van ChatGPT gebruiken om te zien hoeveel tokens jouw tekst bevat (inclusief de bijbehorende token-ID’s).

Waarom tokenisatie belangrijk is

Tokenisatie begrijpen is belangrijk voor iedereen die met LLM’s werkt, omdat het invloed heeft op:

- Kosten beheer: Het aantal tokens bepaalt direct de API-kosten.

- Prestatie-optimalisatie: Efficiënte tokenisatie zorgt voor betere modelprestaties.

- Prompt engineering: Weten hoe tekst wordt getokeniseerd helpt je effectievere prompts te schrijven.

Tokenisatie lijkt misschien technisch, maar het is essentieel om te begrijpen hoe LLM’s taal verwerken en begrijpen. Bij DataNorth helpen we bedrijven om kunstmatige intelligentie te benutten en te implementeren in hun bedrijfsvoering.

Benieuwd hoe AI jouw processen kan optimaliseren en vergemakkelijken? Neem vandaag nog contact op met DataNorth AI en ontdek de mogelijkheden!