De Europese AI verordening (EU AI Act) is wetgeving die de toekomst van AI-governance wereldwijd vormgeeft. Als jouw organisatie AI ontwerpt of gebruikt in Europa, is begrip van de risicogebaseerde classificatie en naleving stappen van de verordening essentieel voor juridisch, ethisch en reputatie -succes. In dit uitgebreide artikel vind je een helder overzicht van de eisen van de AI-verordening, praktische stappen voor naleving per risicocategorie, en antwoorden op de meest gestelde bedrijfsvragen.

Wat is de EU AI Act?

De EU AI Act is in 2024 aangenomen en is inmiddels volledig in werking sinds augustus 2026. De act stelt het wereldwijd eerste uitgebreide juridische kader voor AI-systemen vast. Deze classificeert AI in vier verschillende risiconiveaus, elk met bijbehorende juridische verplichtingen. De missie: innovatie stimuleren terwijl gezondheid, veiligheid en grondrechten worden beschermd.

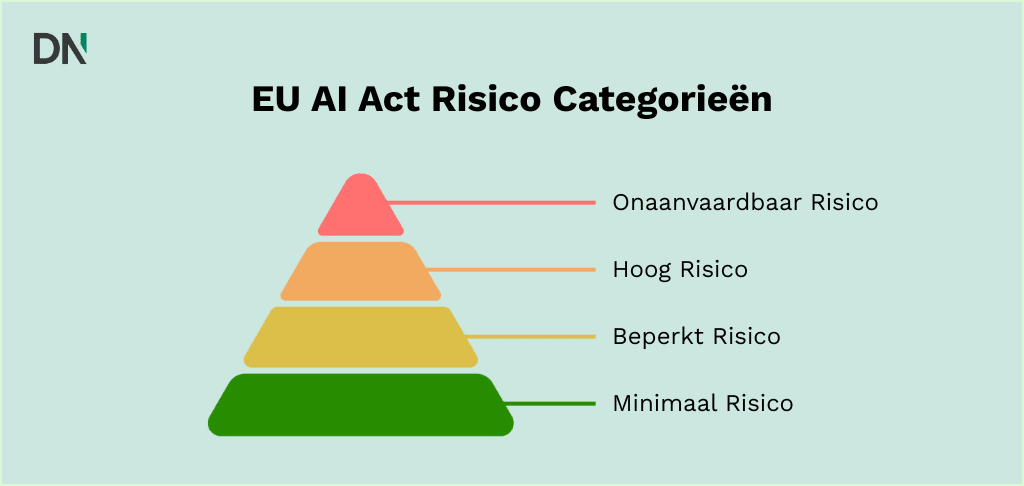

Risicocategorieën EU AI Act: Overzicht en voorbeelden

| Risiconiveau | Voorbeelden | Belangrijkste eisen | Nalevingsdeadline |

| Minimaal/Geen risico | Spamfilters, AI in games, basisanalyses | Geen (maar volg algemene wetgeving) | Al van kracht |

| Beperkt risico | Chatbots, contentgeneratoren, basis deepfakes | Transparantie (gebruikersmelding, outputlabels) | Aug. 2026 (transparantie voor sommige toepassingen begin 2025) |

| Hoog risico | Recruitment AI, kredietscoring, medische AI, handhavingstools | Strikte naleving (risicocontroles, technische documentatie, audits, CE-markering, registratie) | Aug. 2026 |

| Onaanvaardbaar risico | Social scoring, manipulatieve AI, real-time biometrische surveillance | Strikt verbod; mag niet worden ingezet of gebruikt | Al van kracht sinds feb. 2025 |

Voor een officiële samenvatting, zie de risicocategorieën van de EU AI-Act.

Minimaal/geen-risico AI

Het meeste AI-gebruik valt vandaag in deze categorie, denk aan spamfilters, aanbeveling engines, of AI-functies in videospellen. Er worden geen nieuwe verplichtingen toegevoegd bovenop bestaande wetgeving zoals de AVG, consumentenbescherming of productveiligheid.

Tip: Interne documentatie van je risicoclassificatie is een slimme best practice. Zelfs als de AI-tool in de geen-risico categorie valt, is het raadzaam dit te documenteren voor volledige naleving.

Beperkt-risico AI: Transparantie is essentieel

Deze AI-systemen vereisen dat je gebruikers informeert dat ze interacteren met AI. Voorbeelden:

- Chatbots op websites (“Hallo, ik ben een AI-assistent”)

- AI-gegenereerde blogposts, afbeeldingen of video’s (moeten gelabeld of gemarkeerd zijn als AI-gegenereerd)

- Basis emotieherkenning tools in winkels

Nalevingscontrole lijst:

- Stel gebruikers op de hoogte bij de eerste interactie in duidelijke, toegankelijke taal

- Label of markeer synthetische AI-content (afbeeldingen, video’s, deepfakes)

- Houd een overzicht bij van je transparantie maatregelen

Hoog-risico AI: Strikte naleving

Als je AI past binnen een van deze domeinen (zie Bijlage III van de AI-verordening), dan heb je te maken met de strengste verplichtingen:

- Biometrische identificatie/categorisering (gezichtsherkenning).

- Veiligheid kritieke infrastructuur (elektriciteitsnet, vervoerscontrole).

- Onderwijs en werkgelegenheid (student beoordelingen, cv-screening).

- Toegang tot essentiële diensten (credit scoring, verzekeringen, uitkeringen).

- Handhaving en grenscontrole.

- Justitie of democratie (voorspelling uitkomst rechtszaken, verkiezing microtargeting).

- Gereguleerde productveiligheid (bijv. automotive, medische apparaten met ingebouwde AI).

Belangrijkste eisen:

- Implementeer een risicomanagementsysteem en kwaliteitsmanagementsysteem.

- Controleer trainingsdata op vooringenomenheid; zorg voor rigoureus data bestuur.

- Bereid uitgebreide technische documentatie en logs voor.

- Bouw betekenisvol menselijk toezicht en de mogelijkheid tot ingrijpen of override.

- Doorloop een conformiteitsbeoordeling (intern of door derde partij).

- Registreer en CE-markeer het AI-systeem voor lancering.

- Monitor prestaties na implementatie en rapporteer incidenten.

Zware boetes (tot €15 miljoen of 3% van wereldwijde omzet) zijn van toepassing bij niet-naleving.

Onaanvaardbaar-risico AI: Niet bouwen of inzetten

Sommige AI-systemen zijn volledig verboden. Deze omvatten:

- AI die kwetsbare groepen manipuleert (bijv. kinderen)

- Overheid gedreven social scoring (zoals een “social credit” systeem)

- Bepaalde real-time biometrische surveillance (bijv. automatische gezichtsherkenning in het openbaar)

- Misleidende of manipulatieve AI (bijv. kinderen dwingen via slimme speelgoed)

- Emotieherkenning in gevoelige settings (werk, school)

Als je project in deze categorie valt, moet je de ontwikkeling of het gebruik beëindigen. Er is geen naleving route. Zware boetes (tot €35 miljoen of 7% van wereldwijde omzet) zijn van toepassing bij niet-naleving.

Ga direct naar Artikel 5 van de EU AI-verordening voor de officiële lijst van verboden praktijken.

Hoe classificeer je voor de EU AI Act: Stap-voor-stap gids

- Screen op onaanvaardbaar risico: Doet de AI iets van de verboden lijst? (bijv. overheids-social scoring, manipulatieve beïnvloeding?) Zo ja, dan is het niet toegestaan.

- Controleer op hoog risico: Valt jouw AI in een Bijlage III-domein, of is het een veiligheidscomponent in een gereguleerd product? Zo ja, dan moet je het strikte regime naleven.

- Evalueer op beperkt risico: Interacteert jouw AI met gebruikers of produceert het content die verkeerd geïnterpreteerd kan worden als menselijk of echt? Zo ja, pas transparantie-eisen toe.

- Standaard naar minimaal risico: Als geen van bovenstaande, volg reguliere wetgeving en best practices. Documenteer je redenering.

- Documenteer je beslissing: Houd een schriftelijk record bij van je risicoclassificatie, vooral voor grensgevallen of uitzonderingen.

Voor officiële ondersteuning, raadpleeg de officiële EU AI-Act FAQ.

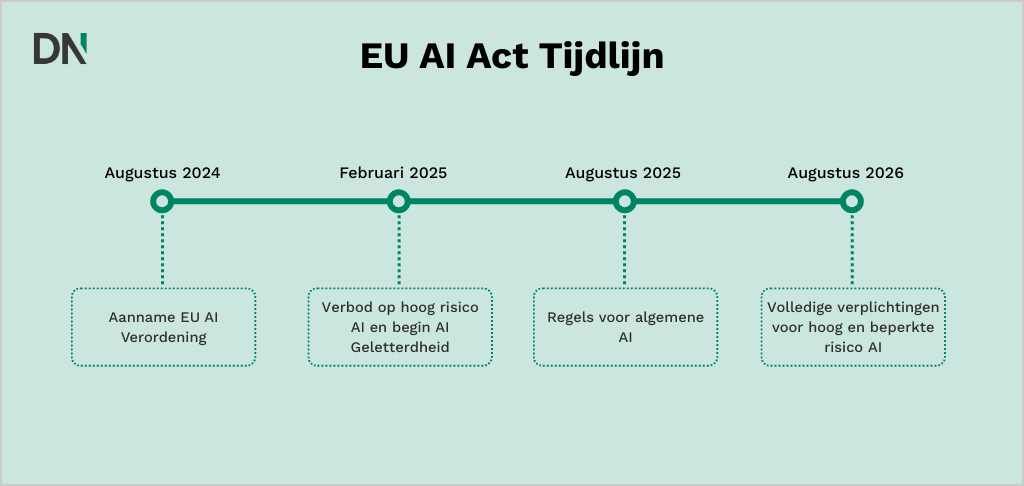

Naleving tijdlijn van de EU AI Act: Wat gebeurt wanneer?

- Februari 2024: Aanname van de EU AI-verordening

- Februari 2025: Verbod op onaanvaardbaar-risico AI is afdwingbaar

- Augustus 2025: Regels voor algemene AI (bijv. voor grote taalmodellen) treden in werking

- Augustus 2026: Volledige verplichtingen voor hoog-risico en beperkt-risico AI-systemen zijn verplicht

Actiestappen voor bedrijven

Aanpassen aan de EU AI-verordening is niet alleen een juridische noodzaak, het is ook een strategische kans. Door naleving versterk je vertrouwen en maak je de AI-projecten van je organisatie toekomstbestendig. Welke concrete maatregelen moet je nu nemen om voorbereid te zijn en voorop te lopen?

1. Voer een uitgebreide AI-inventarisatie uit

Bekijk systematisch alle AI-gestuurde systemen, tools en projecten binnen je organisatie. Identificeer waar en hoe AI wordt gebruikt, categoriseer elk systeem naar doel (bijv. klantenservice, analyses, automatisering), en documenteer implementatie contexten. Deze fundamentele audit onthult naleving lacunes en informeert je volgende acties.

2. Classificeer elk AI-systeem per risiconiveau

Pas het vier-stappen risico beoordelingsproces van de EU AI-verordening toe op elk AI-systeem in gebruik of in ontwikkeling. Beoordeel voor elk systeem of het valt onder onaanvaardbaar, hoog, beperkt, of minimaal risico volgens de officiële criteria van de verordening. Waar classificatie onduidelijk is, documenteer je redenering en raadpleeg AI-nalevingsexperts indien nodig.

3. Documenteer processen en onderhoud naleving records

Houd gedetailleerde, versie gecontroleerde records bij van alle risicobeoordelingen, beslissingen en naleving maatregelen. Deze documenten zijn cruciaal om verantwoording af te leggen als toezichthouders om bewijs van naleving vragen of als je gebruik evolueert. Het verstrekken van incorrecte informatie aan autoriteiten kan leiden tot boetes tot €7,5 miljoen of 1,5% van de jaaromzet.

4. Implementeer controles en transparantie maatregelen

Update regelmatig controles naarmate je systemen of regelgeving evolueren. Stem je controles af op risicoclassificatie:

- Voor hoog-risico AI: Rol robuuste risicomanagement- en kwaliteitsmanagementsystemen uit, zorg voor data- en model audit trails, voltooi technische documentatie, en bereid voor op conformiteitsbeoordeling en CE-markering.

- Voor beperkt-risico AI: Ontwikkel transparante communicatieprotocollen met gebruikers en label AI-generated content duidelijk.

- Voor minimaal risico: Zorg voor voortdurende naleving van algemene juridische standaarden en best practices.

5. Monitor, her-evalueer en blijf flexibel

Stel een periodiek evaluatieproces op om veranderingen in AI-gebruik, technologie of regelgeving te volgen. Her-classificeer en update naleving maatregelen als je systemen of hun gebruik verandert, bijvoorbeeld als een chatbot uitbreidt naar het verwerken van persoonlijke data of kritiek advies geeft.

Conclusie: Waarom proactieve AI-naleving belangrijk is

De EU AI-verordening luidt een nieuw tijdperk van risico-proportionele regulering in. De strengste standaarden gelden voor systemen met de grootste maatschappelijke impact, en lage-risico technologieën genieten een zachtere aanpak. Door vroeg in naleving te investeren, verminder je niet alleen het risico op sancties en verstoring maar inspireer je ook vertrouwen bij gebruikers en stakeholders. Dit resulteert in een concurrentievoordeel naarmate AI-adoptie verder groeit.

Een praktische manier om te beginnen is het implementeren van bovenstaand actieplan: begin met het in kaart brengen van je huidige en geplande AI-implementaties, beoordeel hun risiconiveaus, en start onmiddellijk met documentatie. Proactieve stappen vandaag betekenen minder verrassingen morgen en zorgen ervoor dat je innovaties kunnen gedijen binnen dit nieuwe, vertrouwde AI-ecosysteem.

Blijf op de hoogte door de Europese Commissie en EU AI-verordening nieuws te volgen. En bij twijfel over risicoclassificatie of verplichtingen, zoek gekwalificeerd naleving advies.

Deze gids is gebaseerd op analyse van de AI-verordening en toonaangevende juridische/industriële commentaren.